Snowflake lanceert Arctic: het meest open, enterprise-grade Large Language Model

Datacloudbedrijf Snowflake (NYSE: SNOW) kondigt Snowflake Arctic aan, een state-of-the-art large language model (LLM) dat is ontworpen om het meest open enterprise-grade LLM in de markt te zijn. Dankzij de unieke Mixture-of-Experts (MoE) architectuur, levert Arctic top-tier intelligentie met ongeëvenaarde efficiëntie op schaal. Het is geoptimaliseerd voor complexe enterprise-workloads en overtreft verschillende industrie-benchmarks op het gebied van SQL-codegeneratie, het volgen van instructies, en nog veel meer. Bovendien geeft Snowflake de Arctic-weights vrij onder een Apache 2.0-licentie én de details van het onderzoek dat heeft geleid tot hoe het model is getraind. Hiermee wordt een nieuwe standaard op het gebied van openheid voor enterprise AI-technologie gezet. Het Snowflake Arctic LLM is een onderdeel van de Snowflake Arctic-modelfamilie, een familie van modellen gebouwd door Snowflake die ook het beste praktische tekstinvoegmodel bevatten.

“Dit is een keerpunt voor Snowflake, met ons AI-onderzoeksteam dat innoveert in de voorhoede van AI,” zegt Sridhar Ramaswamy, CEO van Snowflake. “Door het leveren van toonaangevende intelligentie en efficiëntie op een open manier aan de AI-gemeenschap, verleggen we de grenzen van wat open source AI kan doen. Onderzoek met Arctic zal ons vermogen om betrouwbare, efficiënte AI te leveren aan onze klanten aanzienlijk vergroten."

Arctic baanbrekend dankzij écht open, breed beschikbare samenwerking

Volgens een recent Forrester-rapport van Forrester heeft ongeveer 46 procent van de AI-beslissers in bedrijven wereldwijd opgemerkt dat ze gebruikmaken van bestaande open source LLM's om generatieve AI te gebruiken als onderdeel van de AI-strategie van hun organisatie.1 Met Snowflake als datafundament voor meer dan 9.400 bedrijven en organisaties over de hele wereld2, stelt het alle gebruikers in staat om hun data te benutten met toonaangevende open LLM's, terwijl het hen flexibiliteit en keuze biedt met welke modellen ze werken.

Met de lancering van Arctic levert Snowflake een krachtig, echt open model met een Apache 2.0-licentie die onbeperkt persoonlijk, onderzoeks- en commercieel gebruik toestaat. Snowflake gaat nog een stap verder en biedt ook code-templates en flexibele inferentie- en trainingsopties, zodat gebruikers snel aan de slag kunnen met het implementeren en aanpassen van Arctic met behulp van de frameworks van hun voorkeur. Deze bevatten NVIDIA NIM met NVIDIA TensorRT-LLM, vLLM en Hugging Face. Voor direct gebruik, is Actic beschikbaar voor serverloze inferentie in Snowflake Cortex, Snowflake’s volledig beheerde service dat machine learning en AI-oplossingen in de Data Cloud biedt. Dit zal ook beschikbaar zijn op Amazon Web Services (AWS), naast andere model gardens en catalogi, die onder meer Hugging Face, Lamini, Microsoft Azure, NVIDIA API catalog, Perplexity, en Together AI omvatten.

Arctic biedt top-tier intelligentie en is toonaangevend in het efficiënt gebruik van resources

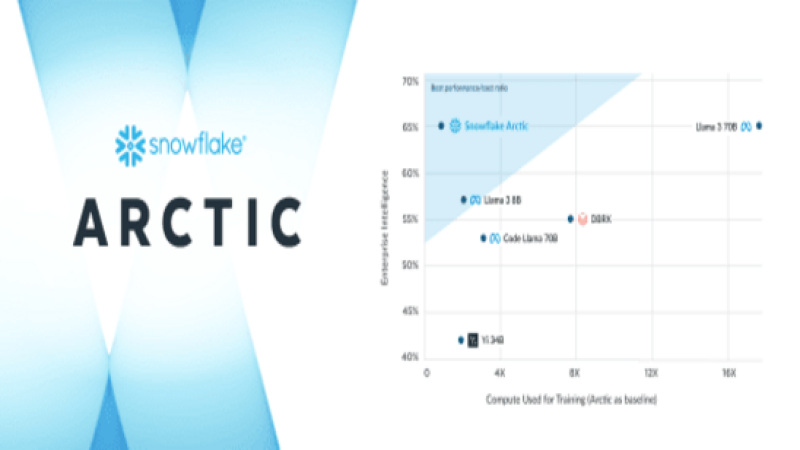

Snowflake's AI-onderzoeksteam, bestaande uit een unieke samenstelling van toonaangevende onderzoekers en system engineers, had minder dan drie maanden nodig en spendeerde grofweg een achtste van de trainingskosten van vergelijkbare modellen bij het bouwen van Arctic. Getraind door het gebruik van Amazon Elastic Compute Cloud (Amazon EC2) P5-instanties, zet Snowlake hiermee een nieuwe basisniveau voor hoe snel state-of-the-art open, enterprise-grade modellen kunnen worden getraind, waardoor gebruikers uiteindelijk kostenefficiënte aangepaste modellen op schaal kunnen maken.

Als onderdeel van deze strategische inspanning verbetert het gedifferentieerde MoE-ontwerp van Arctic zowel de trainingssystemen als de modelprestaties, met een zorgvuldig ontworpen datasamenstelling die is gericht op de enterprise-behoeftes. Arctic levert ook resultaten van hoge kwaliteit, waarbij 17 van de 480 miljard parameters tegelijk worden geactiveerd om toonaangevende kwaliteit te bereiken met een ongekende tokenefficiëntie. Voor een doorbraak in efficiëntie activeert Arctic ruwweg 50 procent minder parameters dan DBRX en 75 procent minder dan Llama 3 70B tijdens inferentie of training. Daarnaast presteert het beter dan toonaangevende open modellen, waaronder DBRX, Mixtral-8x7B en meer in codering (HumanEval+, MBPP+) en SQL-generatie (Spider), terwijl het tegelijkertijd toonaangevende prestaties levert in algemeen taalbegrip (MMLU).

Snowflake blijft inzetten op het versnellen van AI-innovatie voor alle gebruikers

Snowflake blijft bedrijven voorzien van de datafundament en geavanceerde AI-bouwstenen die ze nodig hebben om krachtige AI- en machine learning-apps te maken met hun bedrijfsdata. Wanneer Arctic wordt gebruikt in Snowflake Cortex, kunnen klanten sneller productieklare AI-apps op schaal bouwen, binnen de beveiligings- en beheerperimeter van de Data Cloud.

Naast de Arctic LLM omvat de Snowflake Arctic-familie ook de onlangs aangekondigde Arctic embed, een familie van state-of-the-art tekstinbeddingsmodellen die beschikbaar is voor de open source community onder een Apache 2.0 licentie. De familie van vijf modellen is beschikbaar op Hugging Face voor onmiddellijk gebruik en is binnenkort beschikbaar als onderdeel van de Snowflake Cortex embed-functie (in private preview). Deze inbeddingsmodellen zijn geoptimaliseerd om toonaangevende retrievalprestaties te leveren bij ruwweg een derde van de grootte van vergelijkbare modellen. Hierdoor hebben organisaties een krachtige en kosteneffectieve oplossing bij het combineren van eigen datasets met LLM's als onderdeel van een Retrieval Augmented Generation of semantische zoekservice.

Snowflake geeft ook prioriteit aan het verlenen van toegang tot de nieuwste en meest krachtige LLM’s in de Data Cloud, inclusief de recente toevoegingen van Reka en Mistral AI’s-modellen. Bovendien, kondigde Snowflake recent een uitgebreide samenwerking aan met NVIDIA om door te blijven gaan met AI-innovatie. Het full-stack NVIDIA accelerated platform wordt samengebracht met Snowflake's Data Cloud om een veilige en formidabele combinatie van infrastructuur en compute-mogelijkheden te leveren om AI-productiviteit te ontsluiten.

Snowflake Ventures heeft onlangs ook geïnvesteerd in onder meer LandingAI, Mistral AI en Reka om Snowflake's toewijding aan het helpen van klanten om waarde te creëren uit hun bedrijfsdata met LLM's en AI te vergroten.

Reacties op het nieuws van AI-experts

"Snowflake Arctic is klaar om significante resultaten te behalen die ons strategisch partnerschap uitbreiden en AI-toegang, democratisering en innovatie voor iedereen stimuleren", zegt Yoav Shoham, medeoprichter en CEO van AI21 Labs. "We zijn verheugd om te zien hoe Snowflake ondernemingen helpt om de kracht van open source-modellen te benutten, zoals we hebben gedaan met onze recente release van Jamba - het eerste op productie gebaseerde Transformer-SSM-model op basis van Mamba. De voortdurende AI-investeringen van Snowflake zijn een belangrijke factor in onze keuze om verder te bouwen op de Data Cloud, en we kijken ernaar uit om meer waarde te blijven creëren voor onze gezamenlijke klanten."

“Snowflake en AWS delen dezelfde overtuiging dat generatieve AI vrijwel elke klantervaring die we kennen zal transformeren,” zegt David Brown, Vice President Compute and Networking, AWS. "Met AWS was Snowflake in staat zijn infrastructuur aan te passen om de time-to-market voor het trainen van Snowflake Arctic te versnellen. Door gebruik te maken van Amazon EC2 P5 instances met Snowflake's efficiënte trainingssysteem en modelarchitectuur kon Snowflake snel een nieuw, enterprise-grade model ontwikkelen en leveren aan klanten. Met de plannen om Snowflake Arctic beschikbaar te maken op AWS, zullen klanten meer keuze hebben om krachtige AI-technologie te gebruiken om daarmee hun transformatie te versnellen."

"Terwijl het tempo van AI blijft versnellen, heeft Snowflake zich met de lancering van Snowflake Arctic bewezen als een AI-innovator", zegt Shishir Mehrotra, medeoprichter en CEO van Coda. "Onze innovatie- en ontwerpprincipes zijn in lijn met Snowflake's vooruitstrevende benadering van AI en daarbuiten, en we zijn verheugd om een partner te zijn op deze transformatiereis van alledaagse apps en workflows door middel van AI."

"Er is een enorme golf van open-source AI geweest in de afgelopen maanden," zegt Clement Delangue, CEO en mede-oprichter, Hugging Face. "We zijn verheugd dat Snowflake een aanzienlijke bijdrage levert met deze release, niet alleen van het model met een Apache 2.0-licentie, maar ook met details over hoe het is getraind. Het geeft de nodige transparantie en controle voor bedrijven om AI te bouwen en voor het speelveld als geheel om nieuwe wegen in te slaan."

"De visie van Lamini is om AI te democratiseren, zodat iedereen zijn eigen superintelligentie kan bouwen. Wij geloven dat de toekomst van enterprise-AI gebaseerd moet zijn op krachtige open modellen en open samenwerking", zegt Sharon Zhou, medeoprichter en CEO van Lamini. "Snowflake Arctic is belangrijk om die AI-toekomst te ondersteunen. We zijn enthousiast om Arctic te tunen en aan te passen voor zeer nauwkeurige LLM's, waarbij we optimaliseren voor controle, veiligheid en veerkracht voor een dynamisch AI-ecosysteem."

"Bijdragen van de gemeenschap zijn de sleutel tot het ontsluiten van AI-innovatie en het creëren van waarde voor iedereen", zegt Andrew Ng, CEO van Landing AI. "Snowflake's open source release van Arctic is een hele mooie stap voor het beschikbaar maken van geavanceerde modellen voor iedereen om op te finetunen, evalueren en innoveren."

"We zijn verheugd om de keuze van enterprise-klanten in het snel evoluerende AI-landschap te vergroten door de robuuste mogelijkheden van Snowflake's nieuwe LLM-model Arctic naar de Microsoft Azure AI-modelcatalogus te brengen", zegt Eric Boyd, Corporate Vice President, Azure AI Platform van Microsoft. "Onze samenwerking met Snowflake is een voorbeeld van onze toewijding aan het stimuleren van open innovatie en het verleggen van de grenzen van wat AI kan bereiken."

"De voortdurende vooruitgang - en gezonde concurrentie tussen - open source AI-modellen is niet alleen cruciaal voor het succes van Perplexity, maar ook voor de toekomst van het democratiseren van generatieve AI voor iedereen," zegt Aravind Srinivas, medeoprichter en CEO, Perplexity. "We kijken ernaar uit om te experimenteren met Snowflake Arctic om het aan te passen voor ons product, om uiteindelijk nog meer waarde te genereren voor onze eindgebruikers."

"Snowflake en Reka zetten zich in om AI in de handen van elke gebruiker te krijgen, ongeacht hun technische expertise, om bedrijfsresultaten sneller te stimuleren", zegt Dani Yogatama, medeoprichter en CEO van Reka. "Met de lancering van Snowflake Arctic bevordert Snowflake deze visie door echt open grote taalmodellen van wereldklasse binnen handbereik van gebruikers te brengen."

"Als organisatie in de voorhoede van open source AI-onderzoek, modellen en datasets, zijn we verheugd om getuige te zijn van de lancering van Snowflake Arctic," zegt Vipul Ved Prakash, mede-oprichter en CEO, Together AI. "Vooruitgang in het open source AI-landschap komt het hele ecosysteem ten goede en stelt ontwikkelaars en onderzoekers over de hele wereld in staat om impactvolle generatieve AI-modellen te implementeren."