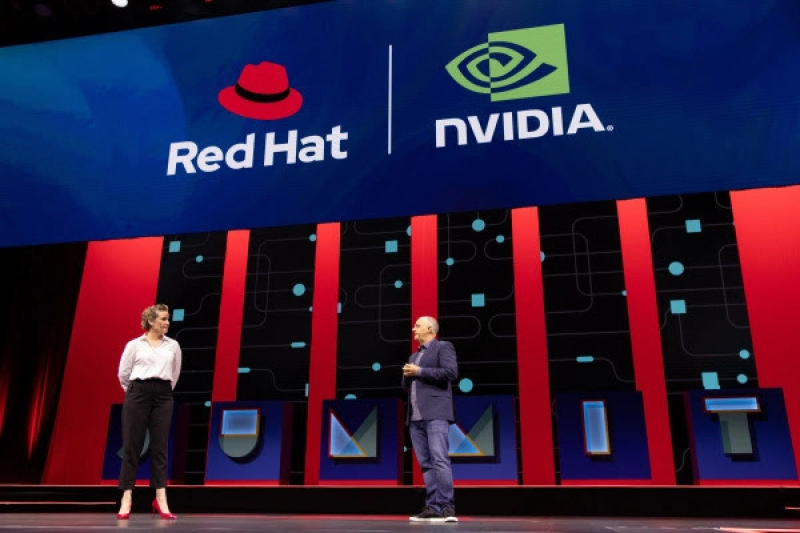

Red Hat versterkt AI-ecosysteem met partnerships NVIDIA, Intel, Stability AI, Run:ai en AMD

Red Hat, Inc., wereldwijd de grootste leverancier van open source-oplossingen, deelt tijdens Red Hat Summit in Denver enkele belangrijke resultaten van samenwerkingen met toonaangevende partners NVIDIA, Intel, AMD, Stability AI en Run:ai. Deze samenwerkingen versterken het AI-ecosysteem van Red Hat’s oplossingen en bieden krachtige mogelijkheden om de efficiëntie te verhogen en kosten te drukken. De aankondigingen werden gedaan tijdens de Red Hat Summit in Denver.

Hardware- en software-ondersteuning met Intel Technologies

De samenwerking met Intel vergemakkelijkt de levering van complete AI-oplossingen oplossingen op Intel AI-producten, waaronder Intel Gaudi AI-accelerators, Intel Xeon-processors, Intel Core Ultra- en Core-processors en Intel Arc GPU's. Deze producten kunnen worden ingezet voor modelontwikkeling, -training, -levering, -beheer en -monitoring in een hybride cloudinfrastructuur.

Daarnaast biedt Intel een verzameling schaalbare en gebruiksklare open source-software die geïntegreerd kan worden met Red Hat OpenShift AI en is gevalideerd voor interoperabiliteit in IT-omgevingen. Ondersteunde software omvat het Intel Tiber Edge Platform, waaronder Intel OpenVINO; Intel Tiber AI Studio; en oneAPI AI Tools. Selecte klanten kunnen toegang vragen tot Intel Gaudi AI-accelerators via de Intel Tiber Developer Cloud.

Lees het volledig Engelstalige persbericht hier

Krachtige integraties met NVIDIA

Aankomende integratieondersteuning voor NVIDIA NIM-microservices op Red Hat OpenShift AI ondersteunt de optimalisering van inferentie. Organisaties kunnen Red Hat OpenShift AI samen met NVIDIA NIM gebruiken – een reeks gebruiksvriendelijke microservices voor inferentie die onderdeel zijn van het NVIDIA AI Enterprise-softwareplatform en de levering versnellen van generatieve AI-applicaties.

Door Red Hat OpenShift AI te gebruiken in combinatie met NVIDIA NIM, kunnen organisaties profiteren van:

- Een gestroomlijnde integratiemethode om NVIDIA NIM te implementeren in een gemeenschappelijke workflow, samen met andere AI-implementaties voor meer consistentie en eenvoudiger beheer.

- Geïntegreerde scaling en monitoring voor NVIDIA NIM-implementaties in afstemming met andere AI-modelimplementaties in hybride cloudomgevingen.

- Hoogwaardige security, support en stabiliteit om een soepele overgang van prototype naar productie te garanderen voor organisaties met een AI-gedreven bedrijfsvoering.

Lees het volledig Engelstalig persbericht hier

GPU-optimalisatie met Run:ai

Red Hat werkt samen met Run:ai aan GPU-optimalisatie via gecertificeerde Operators voor Red Hat OpenShift AI. Deze Operators helpen gebruikers om hun AI-workloads te schalen en te optimaliseren om GPU-kosten te beperken. Hierdoor kunnen bedrijven optimaal gebruikmaken van de beschikbare AI-resources en zowel menselijke als hardwarematige workflows te verbeteren op een betrouwbaar MLOps-platform voor de grootschalige ontwikkeling van AI-applicaties en -modellen.

Door middel van de Operators van Run:AI kunnen organisaties:

- GPU-gebruik inplannen voor AI workloads om essentiële workloads te prioriteren en ervoor te zorgen dat deze workloads voldoende resources krijgen gealloceerd.

- Fractionele GPU en monitoring inzetten om dynamische resources toe te wijzen op basis van vooraf gedefinieerd beleid om de efficiëntie van de infrastructuur te verbeteren.

- Controle en zichtbaarheid op gedeelde GPU-infrastructuur verbeteren voor makkelijkere toegang en resource-allocatie tussen IT-teams, datawetenschappers en applicatie development teams.

Lees hier het volledig Engelstalig persbericht over de samenwerking met Run:AI

GPU-optimalisatie met AMD

Ook AMD werkt samen met Red Hat aan GPU-optimalisatie via gecertificeerde Operators voor Red Hat OpenShift AI. Door middel van de Operators van AMD kunnen organisaties daarbij ook bestaande en toekomstige beperkingen in de GPU-supply chain mitigeren dan wel overwinnen.

Lees hier het volledige Engelstalige persbericht over de samenwerking met AMD

Integratie van de open Stability AI-modellen

Stability AI integreert zijn open AI-modellen met Red Hat OpenShift AI. Hierdoor krijgen Red Hat OpenShift AI-gebruikers toegang tot hypermoderne, open source LLM’s om AI-use cases te ontwikkelen en testen. Daarbij biedt Red Hat OpenShift AI een krachtig AI-applicatieplatform voor onder meer datavergaring, modeltraining en -finetuning, terwijl Stability AI helpt om het juiste model te vinden voor de juiste use case en de juiste plek.

Voordelen zijn onder meer:

- De mogelijkheid om te schalen en innoveren, met behoud van controle over data en producten in een vertrouwde omgeving.

- Toegang tot open generatieve AI-modellen voor toepassingen in uiteenlopende sectoren en applicaties.

- Modellen gebouwd met een safety-by-design-benadering om de productintegriteit te borgen tijdens vroege ontwikkelingsstadia.

- Minder security-, compliance- en privacyrisico’s dankzij een beschermde omgeving waarin gebruikers hun AI-strategieën kunnen ontwikkelen.

- Lagere kosten voor het testen van AI-use cases binnen het Red Hat OpenShift AI-platform.